Sử dụng các mô hình ngôn ngữ lời nói mở rộng chuyển văn bản thành giọng nói tương đương con người thông qua việc truyền bá phong cách và đào tạo do Phạm Thị Miên (Phân hiệu tại Thành phố Hồ Chí Minh, Trường Đại học Giao thông vận tải) - Đào Thị Phương Thúy (Khoa Công nghệ và Kỹ thuật, Trường Đại học Thái Bình) thực hiện

TÓM TẮT:

Bài viết nghiên cứu “Sử dụng các mô hình ngôn ngữ lời nói mở rộng chuyển văn bản thành giọng nói tương đương con người thông qua việc truyền bá phong cách và đào tạo”. Kết quả nghiên cứu đã cho thấy phương pháp này có thể phản ánh hiệu quả các đặc điểm phong cách từ âm thanh tham chiếu. Hơn nữa, Style vectơ từ mô hình, tác giả mã hóa một tập hợp thông tin phong phú có trong âm thanh tham chiếu, bao gồm cao độ, năng lượng, tốc độ nói, chuyển tiếp biểu mẫu và nhận dạng người nói.

Từ khóa: ngôn ngữ, chuyển văn bản thành giọng nói, Voice Clone, Text-to-speech, truyền bá phong cách và đào tạo.

1. Đặt vấn đề

Chuyển văn bản thành giọng nói (TTS), còn được biết đến với tên gọi tổng hợp giọng nói, đã đạt được tiến triển đáng kể với sự xuất hiện của học sâu, tạo ra giọng tổng hợp ngày càng giống giọng người [1]. Tuy nhiên, thách thức vẫn là việc tạo ra giọng nói biểu cảm, bao gồm toàn bộ phổ âm, thời gian và đặc trưng phổ, còn được biết đến là thông tin về ngôn ngữ [2]. Nhiều chiến lược đã được đề xuất để giải quyết thách thức này, bao gồm các phương pháp dựa trên suy luận biến thiên, mô hình dựa trên dòng chảy [1], kiểm soát âm, thời gian và năng lượng và sử dụng bộ mã hóa ngôn ngữ bên ngoại [3]. Mặc dù với những nỗ lực trên, nhưng quá trình tổng hợp giọng nói vẫn chưa thực sự đạt được giọng nói người thật, đặc biệt trong việc mô hình chính xác các phong cách nói và tông điệu cảm xúc của các người nói khác nhau.

Mô hình StyleTTS là một mô hình giải quyết các thách thức nêu trên. StyleTTS tích hợp mô hình sinh dựa trên phong cách vào khung TTS song song để cho phép tổng hợp giọng nói tự nhiên và biểu cảm. Nó tận dụng AdaIN để tích hợp vectơ phong cách tạo ra từ âm thanh tham chiếu, nắm bắt toàn bộ phổ chức năng của đặc điểm phong cách của người nói. Điều này cho phép mô hình trong nghiên cứu tổng hợp giọng nói mô phỏng các mẫu âm vị và tông điệu cảm xúc trong âm thanh tham chiếu. Với nhiều âm thanh tham chiếu khác nhau, nghiên cứu có thể tổng hợp cùng một văn bản theo nhiều phong cách nói khác nhau, thực hiện một ánh xạ một hoặc nhiều mà nhiều hệ thống TTS thường gặp khó khăn.

Trong khi đó, Voice Clone là kết hợp các kỹ thuật học máy và xử lý tín hiệu âm thanh để tạo ra một hệ thống có khả năng sao chép giọng nói chất lượng cao và linh hoạt. Mục tiêu chính của nghiên cứu là phát triển một mô hình giọng nói đa chiều sâu sắc, có khả năng tái tạo cả ngữ âm điệu và đặc trưng cá nhân của người mẫu giọng nói. Sự kết hợp của mạng học sâu và các thuật toán học máy tiên tiến được sử dụng để tối ưu hóa quá trình học và tạo ra một biểu diễn giọng nói chất lượng cao.

Ứng dụng của Voice Clone có thể đặt ra trong nhiều lĩnh vực, bao gồm giả mạo giọng nói trong các ứng dụng trí tuệ nhân tạo, gọi điện thoại tự động và thậm chí tạo ra các nhân vật giọng nói độc đáo trong lĩnh vực giải trí đa phương tiện. Điều này sẽ mang lại đóng góp quan trọng cho việc phát triển các công nghệ sao chép giọng nói và mở ra những khả năng mới trong tương tác giọng nói máy người.

2. Các nội dung chính

2.1. Kỹ thuật chuẩn hóa Adaptive Instance Normalization (AdaIN)

Adaptive Instance Normalization (AdaIN) là một kỹ thuật chuẩn hóa trong mạng nơ-ron sâu, thường được sử dụng trong các mô hình sinh ảnh như StyleGAN và một số biến thể của nó. AdaIN kết hợp cả Instance Normalization (IN) và Adaptive Normalization để tạo ra các kết quả tổng hợp hình ảnh chất lượng cao và mang phong cách.

- Instance Normalization (IN) thường được sử dụng để chuẩn hóa các tính năng của một ảnh hoặc một lớp cụ thể của một mạng nơ-ron. Với mỗi kênh tính năng, IN sẽ thực hiện các bước sau:

+ Tính toán trung bình và độ lệch chuẩn của mỗi kênh trên toàn bộ hình ảnh.

+ Dùng các giá trị trung bình và độ lệch chuẩn tính được để chuẩn hóa mỗi kênh độc lập.

Quá trình này giúp các tính năng trở nên độc lập với cỡ ảnh và giúp tạo ra hình ảnh có chất lượng cao hơn.

- Adaptive Normalization, cũng được gọi là Feature-wise Transformation, thực hiện chuẩn hóa dựa trên các tham số học được từ dữ liệu. Thay vì sử dụng trung bình và độ lệch chuẩn cố định, nó sẽ học các tham số thích hợp cho mỗi kênh tính năng từ dữ liệu đầu vào.

AdaIN kết hợp cả hai kỹ thuật trên. Đầu tiên, nó sẽ tính toán trung bình và độ lệch chuẩn của mỗi kênh trên hình ảnh đầu vào. Sau đó, nó sẽ sử dụng các tham số học được từ một tensor khác (thường là một vector hoặc một tensor nhỏ) để điều chỉnh trung bình và độ lệch chuẩn tính được. Điều này cho phép AdaIN thực hiện chuẩn hóa dựa trên phong cách của ảnh đầu vào.

2.2. Phương pháp

2.2.1. Tổng hợp giọng nói đa phong cách

Cho t ϵ T là các phoneme đầu vào và x ϵ X là một mel-spectrogram tham chiếu tùy ý, mục tiêu là huấn luyện một hệ thống tạo ra mel-spectrogram x̃ ϵ X tương ứng với giọng điệu của t và phản ánh các phong cách nói chung của x. Phong cách nói chung được định nghĩa là bất kỳ đặc điểm nào trong âm thanh tham chiếu x ngoại trừ nội dung phổ âm, bao gồm nhưng không giới hạn là mô hình âm vị, căng cơ, chuyển đổi formants, tốc độ nói và danh tính người nói. Để thực hiện ta cần chia ra 3 loại module chính, gồm: (i) các module tạo ra giọng nói bao gồm Text Encoder, Style Encoder và Decoder; (ii) các module dự đoán TTS bao gồm Duration và Prosody Prediction; (iii) các module tiện ích chỉ được sử dụng trong quá trình đào tạo bao gồm Discriminator, Text Aligner và Pitch Extractor.

Text Encoder: Bộ mã văn bản T chuyển đổi các phoneme t thành một biểu diễn ẩn htext = T(t). Nó bao gồm một CNN 3 lớp theo sau là một LSTM 2 chiều [11].

Text Aligner: Bộ làm đồng bộ văn bản A tạo ra một sự phù hợp dalign giữa mel-spectrogram và phoneme. Tác giả huấn luyện một bộ làm đồng bộ văn bản A cùng với giải mã G trong giai đoạn tái tạo. Mô phỏng theo giải mã của Tacotron 2 với chú ý, A được huấn luyện ban đầu trong nhiệm vụ nhận dạng giọng nói tự động (ASR) bằng cách sử dụng tập dữ liệu LibriSpeech [10], sau đó được điều chỉnh đồng thời với giải mã của tác giả. Tác giả gọi 1 bộ làm đồng bộ văn bản với thiết lập này (được huấn luyện trước trên các bộ dữ liệu lớn và được điều chỉnh cho các nhiệm vụ TTS) là Transferable Monotonic Aligner (TMA).

Style Encoder: Cho 1 mel-spectrogram đầu vào x, bộ mã của tác giả tạo ra một vectơ phong cách s = E(x). Với nhiều âm thanh tham chiếu khác nhau, E có thể tạo ra các biểu diễn phong cách đa dạng, cho phép giải mã G tạo ra giọng nói phản ánh phong cách s của 1 âm thanh tham chiếu x. E bao gồm 4 khối dư dội [12] theo sau là 1 lớp lọc trung bình theo trục thời gian.

Pitch Extractor: Như trong FastPitch [3], tác giả trích xuất tần số F0 trực tiếp ở Hertz mà không cần xử lý thêm, mang lại biểu diễn đơn giản hóa hơn và cho phép kiểm soát nâng cao của tần số nói. Thay vì sử dụng phương pháp phát hiện chu kỳ âm thanh [13] được sử dụng trong FastPitch để ước lượng tần số thực tế, tác giả huấn luyện 1 trích xuất tần số F end-to-end với giải mã để có ước lượng chính xác hơn. Trích xuất tần số là một mạng JDC [14], được huấn luyện trước trên LibriSpeech với F0 thực tế được ước lượng bằng YIN [15]. Trích xuất này được điều chỉnh lại với giải mã để dự đoán tần số px = F(x) cho việc tái tạo của x.

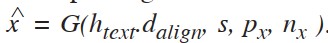

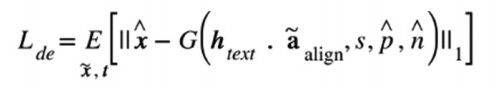

Decoder: Giải mã G được huấn luyện để tái tạo mel-spectrogram đầu vào x, được biểu diễn bởi

. Ở đây, htext*dalign là biểu diễn ẩn được làm phẳng của các phoneme đã được làm đồng bộ, s = E(s) là style vector của x, px là đường đi tần số của x và nx là năng lượng (được biểu diễn bằng norm log) của x mỗi frame. Giải mã bao gồm 7 khối dư dội với AdaIN [6].

(1)

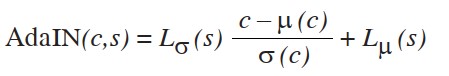

Trong đó, c là một kênh đơn của các bản đồ đặc trưng, s là style vector, µ(·) và σ(·) biểu thị giá trị trung bình và độ lệch chuẩn của kênh và Lσ và Lµ là các chiếu chiến lược tuyến tính đã được học để tính toán adaptive gain và bias bằng cách sử dụng style vector s. Việc sử dụng AdaIN là 1 trong những khác biệt lớn giữa mô hình của tác giả và các mô hình TTS khác có bộ Style Encoder như [4].

Để ngăn chất lượng của các đặc trưng quan trọng bị giảm, tác giả nối tần số px, năng lượng nx và các đặc trưng nguyên thể của phoneme cuối cùng hres tiếp đó đưa chúng vào các khối nguyên thể sau AdaIN.

Discriminator: bao gồm một bộ phân biệt D để hỗ trợ việc huấn luyện giải mã để có chất lượng âm thanh tốt hơn [1].

Duration Predictor: bao gồm 1 LSTM 2 chiều 3 lớp R với module chuẩn hóa lớp được điều chỉnh theo tầng động [16] sau là 1 linear projection L. Duration Predictor được chia sẻ với Prosody Predictor P thông qua hprosody = R(htext) được đưa vào P.

Prosody Predictor: dự đoán cả tần số p̂x và năng lượng n̂x với văn bản và style vector đã cho. Biểu diễn chia sẻ đã được làm đồng bộ hprosody*a được xử lý thông qua 1 lớp LSTM 2 chiều được chia sẻ để tạo ra hprosody, sau đó được đưa vào 2 bộ 3 khối dư dội với AdaIN và một lớp linear projection, 1 cho đầu ra tần số và 1 cho đầu ra năng lượng.

2.2.2. Mô hình Text-to-speech

Mô hình Text-To-Speech (TTS) là 1 hệ thống tổng hợp giọng nói tự động, chuyển đổi văn bản đầu vào thành âm thanh giọng nói tự nhiên. Mục tiêu chính của mô hình TTS là tạo ra âm thanh có chất lượng cao và tự nhiên, phản ánh cả cấu trúc ngữ pháp và ngữ điệu của văn bản.

Quá trình đào tạo của mô hình được chia thành 2 giai đoạn:

* Giai đoạn 1: mô hình học tái tạo mel-spectrogram từ văn bản, tần số, năng lượng và phong cách.

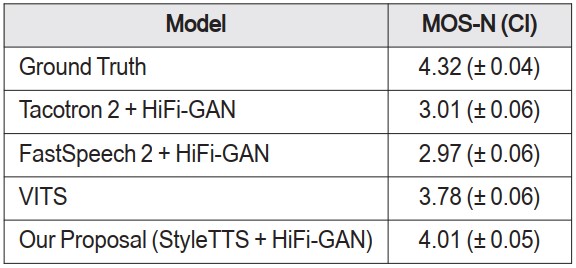

Với 1 mel-spectrogram x ∈ X và văn bản tương ứng t ∈ T, tác giả huấn luyện encoder theo việc tái tạo lại hàm mất mát L1:

Lmel = Ex,t[|| x - G(htext*aalign, s, px, nx) ||1] (2)

Với htext = T(t) là biểu diễn ẩn của phoneme đã được mã hóa, aalign = A(x, t) là sự căn chỉnh chú ý từ Text Aligner, s = E(x) là vectơ phong cách của x, px = F(x) là tần số F0 của x và nx là năng lượng của x. Đối với việc huấn luyện end-to-end (E2E) với Decoder và Text Aligner, áp dụng 1 chiến lược mới 50%-50%: một nửa thời gian, sử dụng đầu ra chú ý gốc như là sự làm đồng bộ, cho phép truyền ngược gradient thông qua bộ làm đồng bộ văn bản. Trong nửa còn lại, tác giả sử dụng phiên bản làm đồng bộ không khác biệt của sự làm đồng bộ chú ý thông qua các thuật toán lập kế hoạch động [9] để huấn luyện giải mã tạo ra giọng nói thông minh từ sự làm đồng bộ cứng theo chiều động trong suốt triển khai. Phương pháp tiếp cận sáng tạo này hiệu quả trong việc điều chỉnh bộ làm đồng bộ văn bản được huấn luyện trước để tạo ra sự làm đồng bộ tối ưu cho tái tạo giọng nói, từ đó nâng cao chất lượng mẫu của giọng nói được tạo ra.

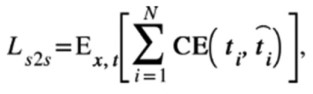

Tác giả điều chỉnh lại Text Aligner bằng sequence-to-sequence ASR objectives Ls2s gốc để đảm bảo sự làm đồng bộ chú ý đúng đắn được duy trì trong quá trình huấn luyện E2E:

Với N là số lượng phoneme trong t, ti là biểu tượng phoneme thứ i của t,

là biểu tượng phoneme được dự đoán thứ i và CE(·) là hàm Cross-Entropy.

Vì sự làm đồng bộ này không nhất thiết phải là một dãy đơn điệu, tác giả sử dụng một mất mát L-1 đơn giản Lmono để đảm bảo đồng bộ giữa Soft Attention Alignment và phiên bản Monotonic không khác biệt:

Lmono = Ex,t[ ||aalign - ahard ||1]

Nơi aalign = A(x,t) làm đồng bộ chú ý và ahard làm đồng bộ cứng đơn điệu được thu được thông qua các thuật toán quy hoạch động.

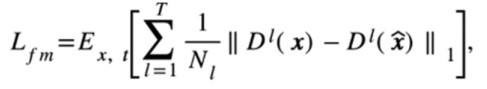

Tác giả sử dụng 2 hàm mất mát Adversarial, hàm mất mát cross-entropy gốc Ladv để đào tạo và bổ sung thêm hàm mất mát feature-matching [43] Lfm để cải thiện chất lượng âm thanh của mel-spectrogram được tái tạo:

Ladv = Ex,t[logD(x) + log1 - D(x̂))],

Với x̂ là mel-spectrogram tái tạo bởi G, T là tổng số lớp trong D và Dl chỉ đến bản đồ tính năng đầu ra của lớp thứ l với Nl Feature. Hàm mất mát phù hợp tính năng có thể được xem xét như một mất mát tái tạo các đặc trưng ẩn của giọng nói thực và được đánh giá bởi bộ phân biệt.

First stage full objectives có thể tóm tắt như sau với các siêu tham số λs2s, λmono, λadv và λfm:

* Giai đoạn 2: huấn luyện để dự đoán thời lượng, tần số,… từ văn bản đã cho.

Tác giả sử dụng mất mát L-1 để đào tạo mô hình dự đoán thời lượng:

Ldur = Ed[ ||d - dpred||1]

Trong đó d là thời lượng thực tế thu được bằng cách cộng aalign dọc theo trục khung mel. dpred = L[R(htext, s)] là thời lượng dự đoán dưới Style Vector s.

Prosody Predictor: huấn luyện mô hình dự đoán điệu của tác giả thông qua một phương pháp tăng dữ liệu độc đáo. Thay vì sử dụng sự đồng bộ giữa thực tế và dự đoán, tần số và năng lượng của mel-spectrogram gốc, áp dụng một phép nội suy tuyến tính 1D để kéo dài hoặc co melspectrogram trong thời gian và thu được mẫu tăng cường x̃. Do đó, tốc độ nói thay đổi, nhưng đường cong tần số và năng lượng vẫn giữ nguyên tính nhất quán. Theo cách này, mô hình dự đoán điệu học cách duy trì tính không biến với tần số và năng lượng, bất kể thời lượng của đoạn nói. Phương pháp này giúp giảm thiểu vấn đề với điệu không tự nhiên khi thời lượng dự đoán là không chính xác.

Tác giả sử dụng Lf0 và Ln, tương ứng với mất mát tái tạo F0 và năng lượng:

Lf0 = Epx̃[||px̃ - Pp(S(htext,s).ãalign)||1]

Ln = Ex̃[||nx̃ - Pn(S(htext,s).ãalign)||1]

Trong đó, px̃, nx̃ và ãalign là tần số, năng lượng và sự đồng bộ của x̃ ∈ X̃ tập dữ liệu được tăng cường. Pp đại diện cho đầu ra của tần số từ mô hình Prosody Prediction và Pn là đầu ra của năng lượng.

Cuối cùng, để đảm bảo rằng tần số và năng lượng dự đoán có thể được sử dụng hiệu quả bởi giải mã. Cho mel-spectrogram được kéo dài hoặc co lại trong quá trình gia tăng dữ liệu, việc sử dụng chúng như làm đồng bộ có thể dẫn đến các hiện tượng không mong muốn trong việc tái tạo điệu. Thay vào đó, huấn luyện mô hình dự đoán điệu để tạo ra dự đoán tần số và năng lượng có thể hiệu quả khi được sử dụng bởi giải mã:

Trong đó, x̂ = G(htext.ãaligh, s, p̃, ||x̃||) là tái tạo của x̃ ∈ X̃, p̂ = Pp(S(htext,s).ãaligh) là tần số dự đoán và n̂ = Pn(S(htext,s).ãaligh) là năng lượng dự đoán.

Mục tiêu đầy đủ giai đoạn thứ hai có thể tóm tắt như sau với các siêu tham số λdur, λf0 và λn:

2.3. Thực nghiệm và đo lường

2.3.1. Bộ dữ liệu

Tác giả đã tiến hành một chuỗi thí nghiệm đa dạng trên 3 bộ dữ liệu khác nhau để đánh giá hiệu suất của mô hình. Trước hết, tác giả đã tập trung vào việc huấn luyện một mô hình chỉ có một người nói trên bộ dữ liệu LJSpeech. Bộ dữ liệu này bao gồm 13,100 đoạn âm thanh ngắn, tổng cộng khoảng 24 giờ, mang đến một thách thức lớn đối với mô hình trong việc học và tái tạo các đặc điểm độc nhất của mỗi người nói. Tác giả đã áp dụng phương pháp chia tách dữ liệu giống như trong mô hình VITS, với bộ huấn luyện chứa 12,500 mẫu, bộ xác thực 100 mẫu và bộ kiểm tra 500 mẫu.

Bên cạnh đó, tác giả đã tiếp tục nghiên cứu bằng cách huấn luyện một mô hình nhiều người nói trên bộ dữ liệu LibriTTS. Phần con train-clean-460 của LibriTTS là một nguồn tài nguyên đáng kể với khoảng 245 giờ âm thanh từ 1,151 người nói. Để đảm bảo tính đa dạng, tác giả loại bỏ các đoạn nói có thời lượng lớn hơn 30 giây hoặc ngắn hơn một giây. Bộ con train-clean-460 được chia ngẫu nhiên thành tập huấn luyện (98%), tập xác thực (1%) và tập kiểm tra (1%), theo phương pháp trong. Sử dụng tập kiểm tra để đánh giá, tác giả thu được thông tin chi tiết về khả năng tổng quát hóa và hiệu suất của mô hình.

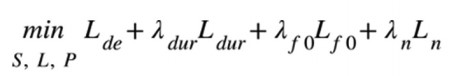

Tác giả đã huấn luyện một mô hình nhiều người nói trên bộ dữ liệu tiếng nói có tính cảm (ESD). Bộ dữ liệu này bao gồm 10 người nói tiếng Trung và 10 người nói tiếng Anh đọc cùng 400 câu ngắn trong năm tình trạng cảm xúc khác nhau. Tác giả đã tăng mẫu âm thanh huấn luyện lên 24 kHz để phù hợp với LibriTTS và chuyển đổi văn bản thành âm vị sử dụng công cụ mã nguồn mở. Bằng cách này, tác giả có thể nghiên cứu khả năng của mô hình trong việc tạo ra âm thanh có đặc tính prosody đa dạng, một yếu tố quan trọng trong việc truyền đạt cảm xúc trong tiếng nói. Tác giả cũng sử dụng các kỹ thuật trích xuất mel-spectrogram tiên tiến để bảo đảm chất lượng và độ chính xác của quá trình tổng hợp âm thanh. (Hình 1)

Hình 1: Bộ dữ liệu

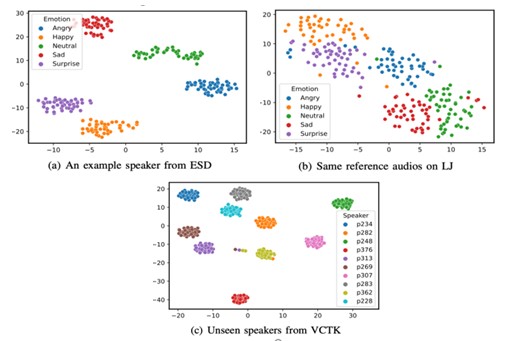

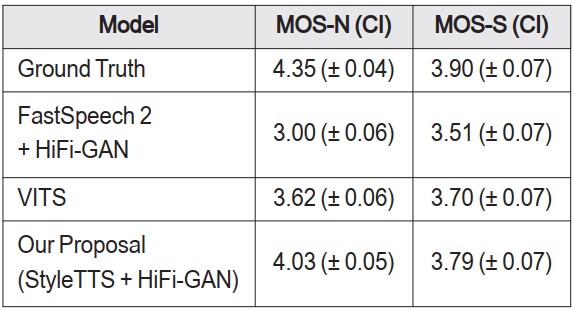

Bảng 1. So sánh điểm mos được đánh giá với khoảng tin cậy 95% (CI) trên bộ dữ liệu LJSPEECH

Bảng 2. So sánh điểm mos được đánh giá với khoảng tin cậy 95% (CI)

trên bộ dữ liệu LIBRITTS

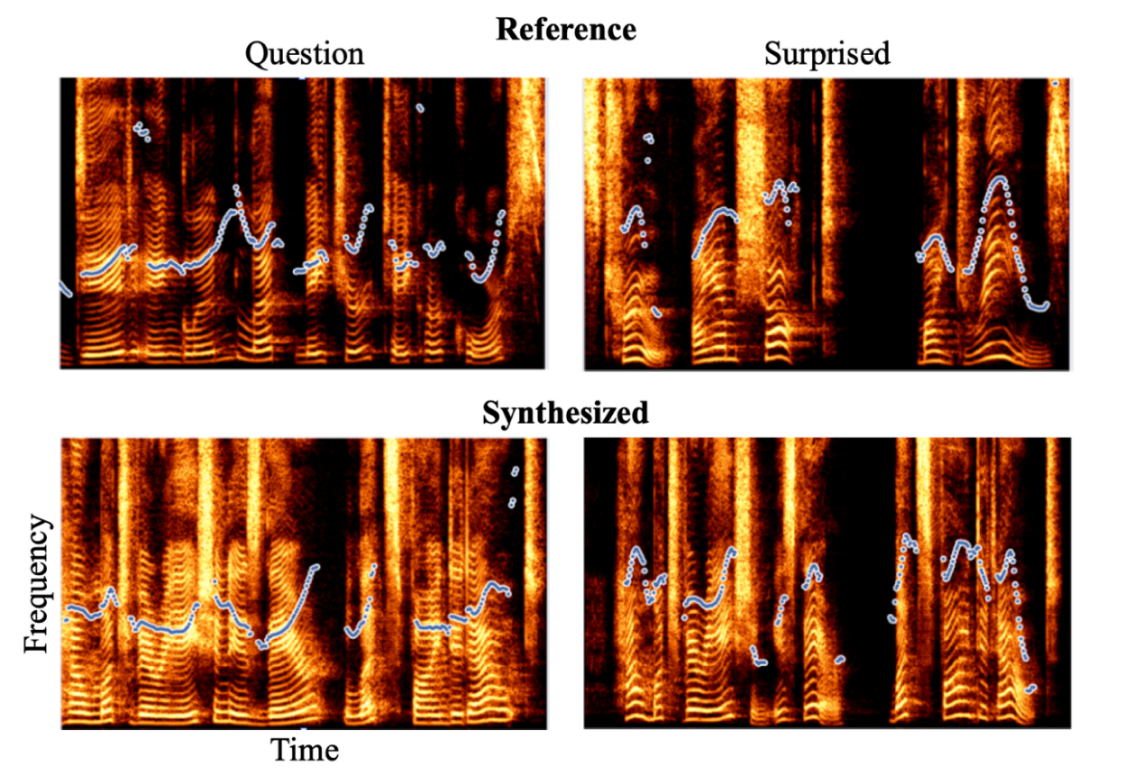

Hình 2: Spectrogram của các audio minh họa

Hình trên đang thể hiện Spectrogram của âm thanh tham chiếu và tiếng nói được tạo ra tương ứng đọc câu "How much variation is there? Let’s find it out." từ mô hình nói đơn được huấn luyện trên bộ dữ liệu LJSpeech. Đường nét nhấn tượng định của giọng đã được biểu diễn bằng các điểm màu trắng. Phía trái trên: Âm thanh tham chiếu của một câu hỏi, "Did England let nature take her course?". Chú ý rằng độ cao của giọng thường tăng lên ở cuối mỗi từ. Phía trái dưới: Tiếng nói được tổng hợp. Mẫu giọng tương tự với độ cao tăng lên ở cuối các từ. Phía phải trên: Âm thanh tham chiếu của một bài nói ngạc nhiên nói "It’s true! I am shocked! My dreams!". Chú ý rằng giọng đi lên trước rồi đi xuống cho mỗi từ. Phía phải dưới: Tiếng nói được tổng hợp với mẫu giọng tương tự của độ cao đi lên và đi xuống cho phần lớn các từ. (Bảng 1, Bảng 2, Hình 2)

3.3.2. Kết quả thực nghiệm

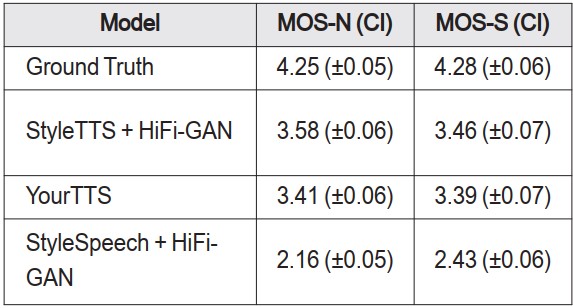

Tác giả đã thực hiện hai đánh giá chủ quan: điểm ý kiến trung bình về độ tự nhiên (MOS-N) để đo độ tự nhiên của giọng nói tổng hợp và điểm ý kiến trung bình về độ tương tự (MOS-S) đánh giá mức độ tương tự giữa giọng nói tổng hợp và tham chiếu cho mô hình nhiều người nói... Trong mọi thử nghiệm, tác giả chọn ngẫu nhiên 100 mẫu văn bản từ bộ thử nghiệm. Đối với mỗi văn bản, tác giả tổng hợp lời nói bằng cách sử dụng mô hình của mình và các mô hình cơ sở, đồng thời đưa thông tin cơ bản vào để so sánh. Các mô hình cơ sở bao gồm Tacorton 2 [4], FastSpeech 2 [5] và VITS [1]. Đối với các thử nghiệm zero-shot speaker, tác giả đã so sánh mô hình của mình với StyleSpeech [7] và YourTTS [8]. Tất cả các mô hình cơ sở đều được đào tạo trước và công khai. Các biểu đồ mel-spectrogram được tạo ra đã được chuyển đổi thành dạng sóng bằng cách sử dụng bộ encoder Hifi-GAN [9] cho tất cả mô hình. Để so sánh công bằng, tác giả đã giảm tần số lấy mẫu âm thanh tổng hợp của mình xuống 22 kHz để khớp với âm thanh từ các mẫu cơ sở. Tác giả đã sử dụng các tham chiếu ngẫu nhiên khi tổng hợp giọng nói cho các thử nghiệm điều chỉnh single-shot speaker và zero-shot speaker.

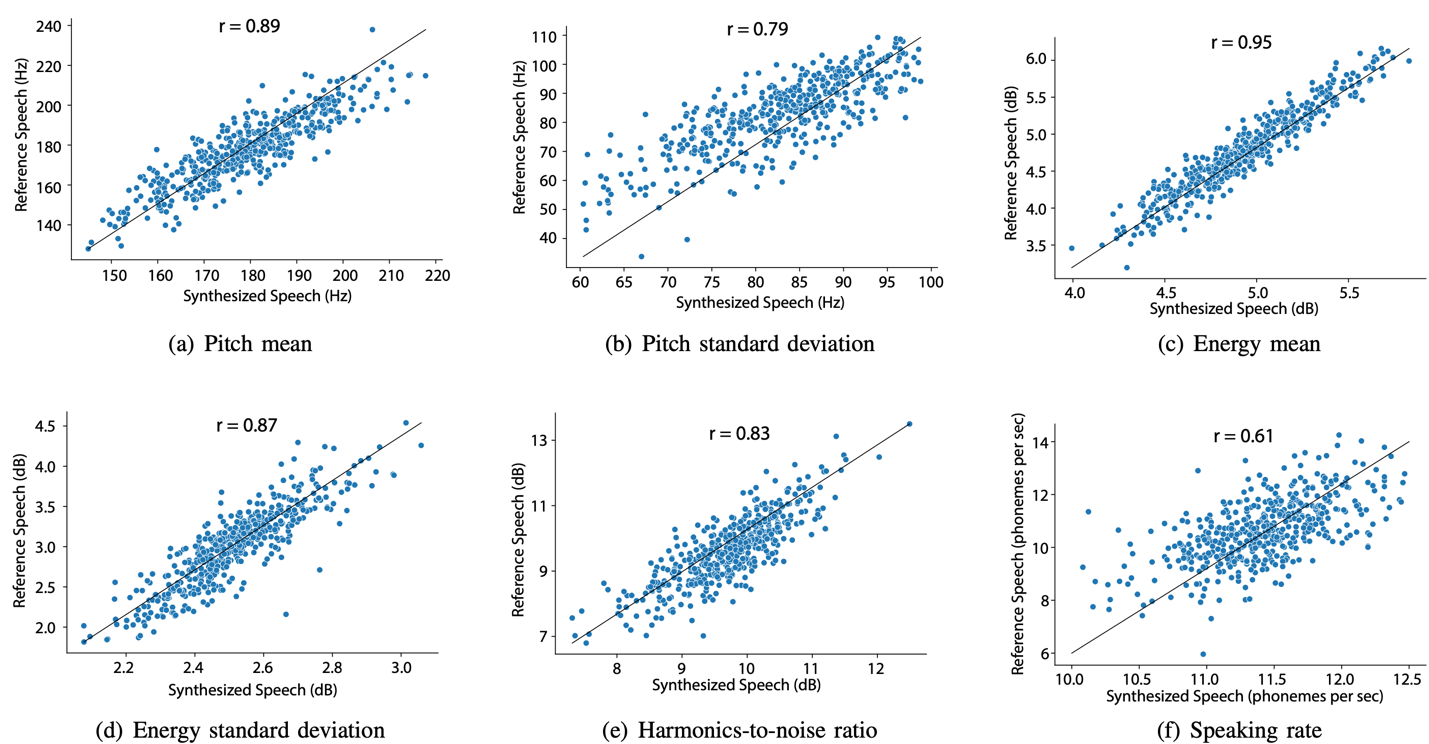

Tác giả cũng tiến hành đánh giá khách quan bằng cách sử dụng số liệu ASR. Tác giả đã đánh giá độ tin cậy của các mô hình đối với các độ dài khác nhau của kiểu nhập văn bản. Với 4 bộ thử nghiệm có độ dài văn bản lần lượt là L < 10, 10 < L < 50, 50 < L < 100 và 100 < L, mỗi bộ chứa 100 văn bản được lấy mẫu từ bộ dữ liệu WSJ0 [17], tác giả đã tính toán tỷ lệ lỗi từ của giọng nói tổng hợp từ cả mô hình một speaker và nhiều speaker bằng cách sử dụng mô hình ASR được đào tạo trước từ ESPnet. Để đo tốc độ suy luận, tác giả đã tính toán hệ số thời gian thực (RFT), biểu thị thời gian (tính bằng giây) cần thiết để mô hình tổng hợp dạng sóng một giây. RFT được đo trên máy chủ có 3 GPU NVIDIA RTX A5000 và batch size là 6. Ngoài ra, tác giả đã tiến hành phân tích tương tự về mối tương quan của các đặc điểm âm thanh liên quan đến cảm xúc giữa giọng nói tham chiếu và giọng nói tổng hợp bằng cách sử dụng 4 mô hình nhiều speaker. Vì không có kiểu trong FastSpeech 2 và VITS, tác giả đã sử dụng mô hình X-vector được đào tạo trước từ Kaldi [18] để trích xuất phần nhúng của loa làm vectơ tham chiếu. (Hình 3)

Hình 3: Hệ số tương quan Pearson của sáu đặc điểm âm thanh liên quan đến cảm xúc

giữa lời nói tham chiếu và lời nói tổng hợp trên bộ dữ liệu LJ Speech

Bảng 3. So sánh mos được đánh giá với khoảng đọ tin cậy (CI) 95%

trên bộ dữ liệu VCTK để điều chỉnh unseen speaker

Bảng 1, 2, 3 trình bày kết quả đánh giá chủ quan của con người trên bộ dữ liệu LJSpeech và LibriTTS. Khi được đánh giá về độ tự nhiên (MOS-N) và độ tương tự (MOS-S), StyleTTS rõ ràng vượt trội so với các mẫu khác, thể hiện hiệu suất vượt trội trong cả single speaker, multi-speaker và zero-shot speaker.

4. Kết luận

Style TTS là một phương pháp tổng hợp văn bản thành giọng nói (TTS) mới lạ và tự nhiên. Nghiên cứu của tác giả thực hiện một bước tiến đặc biệt trong việc tận dụng điểm mạnh của các hệ thống TTS song song với một số cấu trúc mới, bao gồm transferable monotonic aligner (TMA) độc đáo, đồng thời tích hợp thông tin về kiểu dáng thông qua AdaIN. Tác giả đã chứng minh phương pháp này có thể phản ánh hiệu quả các đặc điểm phong cách từ âm thanh tham chiếu. Hơn nữa, Style vectơ từ mô hình, tác giả mã hóa một tập hợp thông tin phong phú có trong âm thanh tham chiếu, bao gồm: cao độ, năng lượng, tốc độ nói, chuyển tiếp biểu mẫu và nhận dạng người nói. Điều này cho phép dễ dàng kiểm soát các mẫu nhịp điệu và tông màu cảm xúc của giọng nói tổng hợp bằng cách chọn kiểu tham chiếu thích hợp, đồng thời hưởng lợi từ việc tổng hợp giọng nói mạnh mẽ và nhanh chóng của các hệ thống TTS song song. Nói chung, chúng cho phép tổng hợp giọng nói tự nhiên, với các phong cách giọng nói đa dạng, vượt xa những gì đã đạt được trong các hệ thống TTS trước đây.

TÀI LIỆU THAM KHẢO:

1. J. Kim, J. Kong, and J. Son, (2021). Conditional variational autoencoder with adversarial learning for end-to-end text-to-speech. Proceedings of Machine Learning Research, 139, 5530-5540.

2. X. Tan, T. Qin, F. Soong, and T.-Y. Liu (2021). A survey on neural speech synthesis. [Online] Available at https://arxiv.org/pdf/2106.15561

3. Y. Ren, C. Hu, X. Tan, T. Qin, S. Zhao, Z. Zhao, and T.-Y. Liu (2021). Fastspeech 2: Fast and high-quality end-to-end text to speech. [Online] Available at https://arxiv.org/pdf/2006.04558

4. R. Liu, B. Sisman, G. lai Gao, and H. Li (2021). Expressive tts training with frame and style reconstruction loss. [Online] Available at https://arxiv.org/pdf/2008.01490

5. Y. Ren, Y. Ruan, X. Tan, T. Qin, S. Zhao, Z. Zhao, and T.-Y. Liu (2019). Fastspeech: fast, robust and controllable text to speech. [Online] Available at https://proceedings.neurips.cc/paper_files/paper/2019/file/f63f65b503e22cb970527f23c9ad7db1-Paper.pdf

6. X. Huang and S. Belongie (2017). Arbitrary style transfer in real-time with adaptive instance normalization. [Online] Available at https://openaccess.thecvf.com/content_ICCV_2017/papers/Huang_Arbitrary_Style_Transfer_ICCV_2017_paper.pdf

7. T. Karras, S. Laine, M. Aittala, J. Hellsten, J. Lehtinen, and T. Aila (2020). Analyzing and improving the image quality of stylegan. [Online] Available at https://arxiv.org/pdf/1912.04958

8. T. Karras, M. Aittala, S. Laine, E. Härkönen, J. Hellsten, J. Lehtinen, and T. Aila (2021). Alias-free generative adversarial networks. [Online] Available at https://arxiv.org/pdf/2106.12423.

9. C.-H. Lee, Z. Liu, L. Wu, and P. Luo (2020). Maskgan: Towards diverse and interactive facial image manipulation. [Online] Available at https://arxiv.org/pdf/1907.11922

10. P. Zhu, R. Abdal, Y. Qin, and P. Wonka (2020). Sean: Image synthesis with semantic region-adaptive normalization. [Online] Available at https://arxiv.org/pdf/1911.12861

11. M. Schuster and K. K. Paliwal (1997). Bidirectional recurrent neural networks. IEEE transactions on Signal Processing, 45(11), 2673-2681.

12. K. He, X. Zhang, S. Ren, and J. Sun (2016). Deep residual learning for image recognition. [Online] Available at https://arxiv.org/pdf/1512.03385

13. P. Boersma et al. (1993). Accurate short-term analysis of the fundamental frequency and the harmonics-to-noise ratio of a sampled sound. Proceedings of the institute of phonetic sciences, 17(1193), 97-110.

14. S. Kum and J. Nam (2019). Joint detection and classification of singing voice melody using convolutional recurrent neural networks. Applied Sciences, 9(7), 1324.

15. A. De Cheveigné and H. Kawahara (2002). Yin, a fundamental frequency estimator for speech and music. The Journal of the Acoustical Society of America, 111(4), 1917-1930.

16. J. L. Ba, J. R. Kiros, and G. E. Hinton (2016). Layer normalization. [Online] Available at https://arxiv.org/pdf/1607.06450

17. J. Garofolo, D. Graff, D. Paul, and D. Pallett (1993). Csr-i (wsj0) complete ldc93s6a. Philadelphia: Linguistic Data Consortium.

18. D. Povey, A. Ghoshal, et. al. (2011). The kaldi speech recognition toolkit. [Online] Available at https://www.danielpovey.com/files/2011_asru_kaldi.pdf

USING EXTENSIVE SPEECH LANGUAGE MODELS

TO CONVERT TEXT INTO HUMAN-EQUIVALENT SPEECH

THROUGH STYLE PROPAGATION AND TRAINING

• PHAM THI MIEN1

• DAO THI PHUONG THUY2

1University of Transport and Communications - Ho Chi Minh City Campus

2Faculty of Technology and Engineering, Thai Binh University

ABSTRACT:

In this study, extensive speech language models were used to convert text into human-equivalent speech through style propagation and training. This study’s results showed that this method can effectively reflect stylistic features from reference audio. Furthermore, from the study’s research model, the Style vector was encoded with a rich set of information contained in the reference audio, including pitch, energy, speaking rate, form transitions, and speaker identity.

Keywords: languages, text-to-speech, Voice Clone, style propagation and training.

[Tạp chí Công Thương - Các kết quả nghiên cứu khoa học và ứng dụng công nghệ, Số 11 tháng 5 năm 2024]