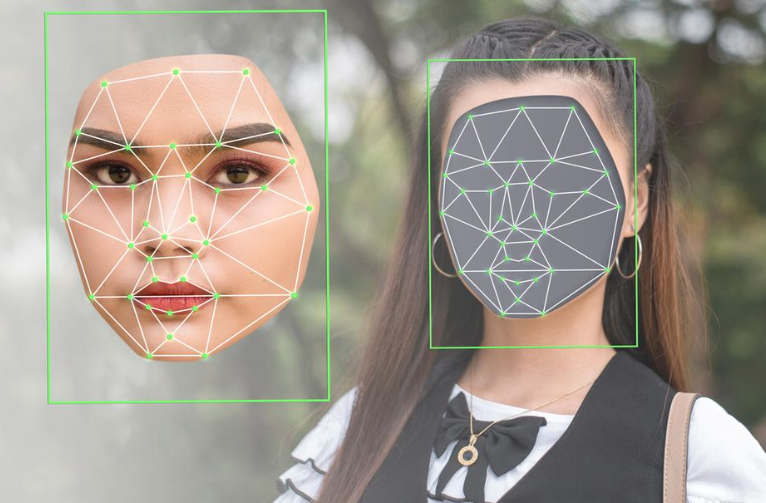

Cơn bão lừa đảo bằng cách giả mạo khuôn mặt, giọng nói của một người nào đó đang ngày càng tăng, đem đến những mối đe dọa tiềm ẩn trên toàn cầu…

Làn sóng lừa đảo giả mạo khuôn mặt và giọng nói bằng công nghệ mang tên deepfake ngày càng phổ biến. Các chuyên gia an ninh mạng cảnh báo tình trạng này dự kiến sẽ trở nên tồi tệ hơn khi các tổ chức an ninh mạng đang phải vật lộn để ngăn chặn làn sóng này.

Tội phạm công nghệ đã khai thác AI để lừa đảo. Những video, âm thanh và hình ảnh của người thật đã được thay đổi, thao tác để xuyên tạc một cách thuyết phục. Từ những hình ảnh phản cảm cho đến các video quảng cáo hay những người nổi tiếng và các chính trị gia của nhiều nước đều trở thành nạn nhân của công nghệ deepfake.

Một trong những vụ án lớn nhất từ đầu năm đến nay là việc một nhân viên tài chính ở Hồng Kông đã bị lừa chuyển hơn 25 triệu USD cho kẻ lừa đảo sử dụng công nghệ deepfake đóng giả giám đốc tài chính của công ty.

Cảnh sát Hồng Kông mới đây cũng cho biết họ đã phá giải 6 vụ án liên quan đến kiểu lừa đảo này. Có 8 chứng minh nhân dân Hồng Kông bị đánh cắp được sử dụng để thực hiện 90 giấy vay nợ và 54 lần đăng ký tài khoản ngân hàng.

Theo cảnh sát, có ít nhất 20 trường hợp lừa đảo với công nghệ deepfake đã bắt chước khuôn mặt từ những bức ảnh trên chứng minh thư.

Truyền thông Trung Quốc cũng đưa tin về một trường hợp tương tự, tại tỉnh Sơn Tây nước này, một nữ nhân viên tài chính bị lừa chuyển 262.000 USD vào tài khoản của kẻ lừa đảo sau cuộc gọi điện video với hình ảnh giả mạo lãnh đạo của cô.

Vào cuối tháng 1/2024, những hình ảnh phản cảm của ngôi sao nhạc pop người Mỹ, Taylor Swift do công nghệ deepfake tạo ra đã lan truyền nhanh chóng trên mạng xã hội, càng nhấn mạnh khả năng gây thiệt hại lớn do công nghệ trí tuệ nhân tạo gây ra.

David Fairman, Giám đốc thông tin và an ninh của công ty an ninh mạng Netskope cho biết, mối đe dọa deepfake ngày càng tăng do sự phổ biến ChatGPT của Open AI, đã nhanh chóng đưa công nghệ AI tổng quát trở thành xu hướng phổ biến.

Fairman cho hay, khả năng tiếp cận công khai của dịch vụ này đã làm hạ thấp rào cản xâm nhập của tội phạm mạng, những tên tội phạm không còn cần kỹ năng công nghệ đặc biệt.

Các công nghệ, dịch vụ AI tổng hợp khác nhau có thể được sử dụng như một công cụ mạnh mẽ cho những kẻ bất hợp pháp đang cố gắng thao túng và giả mạo hình ảnh của một cá nhân nhất định.

Công ty kỹ thuật Arup chia sẻ, giống như nhiều doanh nghiệp khác trên toàn cầu, hoạt động của công ty này thường xuyên bị tấn công, bao gồm gian lận hóa đơn, lừa đảo trực tuyến, giả mạo giọng nói và khuôn mặt.

Các chuyên gia an ninh mạng cũng bày tỏ sự lo lắng về nhiều thủ đoạn khác nhau mà các bức ảnh, video hoặc bài phát biểu giả mạo của lãnh đạo các công ty sẽ được sử dụng theo cách độc hại.

Theo Jason Hogg, giám đốc điều hành tại Great Hill Partners, tin tức giả của những thành viên cấp cao trong các công ty có thể được sử dụng để truyền bá tin xấu nhằm thao túng giá cổ phiếu, bôi xấu thương hiệu làm ảnh hưởng tới doanh số bán hàng.

Nhiều công ty trên toàn thế giới đang tăng cường phòng thủ trước các mối đe dọa của AI bằng việc đào tạo nhân viên, kiểm tra kỹ hệ thống an ninh mạng và yêu cầu xác thực nhiều lớp phê duyệt cho tất cả các giao dịch.

Các cuộc bầu cử cũng dần trở thành một trận chiến giữa sự thật và giả mạo, khi trí tuệ nhân tạo đã trở thành công cụ đe dọa tính minh bạch và công bằng trong quá trình bầu cử dân chủ.

Các chính trị gia giả mạo tạo ra từ công nghệ deepfake đã tác động lớn đến cuộc bầu cử ở Ấn Độ. Công nghệ này cho phép các chính trị gia Ấn Độ có mặt ở mọi lúc mọi nơi trong cuộc bầu cử lớn của thế giới bằng cách nhân bản giọng nói và hình ảnh của họ.

Ngay cả những nhân vật của công chúng đã qua đời cũng được hồi sinh về mặt kỹ thuật số nhằm thu hút sự ủng hộ của công chúng trong cuộc bầu cử dân chủ. Hàng triệu cử tri tại Ấn Độ cảm nhận rằng họ đang trải qua một cuộc tấn công khủng khiếp từ công nghệ deepfake.

Vào đầu năm 2024, khi các cử tri chuẩn bị bỏ phiếu cho cuộc bầu cử sơ bộ, một phiên bản giả giọng nói của Tổng thống Joe Biden được sử dụng trong các cuộc gọi tự động để ngăn cản đảng Dân chủ tham gia cuộc bầu cử này.

Điều đáng lo ngại là mặc dù âm thanh có vẻ giả tạo nhưng lại rất giống tổng thống Mỹ, thậm chí còn sử dụng khẩu hiệu “malarkey” đặc trưng của ông.

Khánh Sơn